深入解析GPT大规模语言模型的工作原理与技术架构

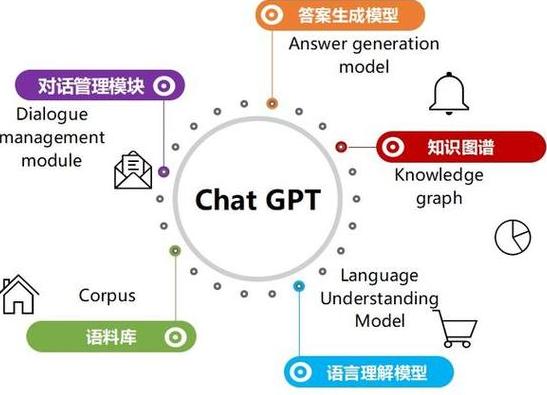

GPT成为了众人瞩目的焦点。本质上,它是一个依托人工智能技术打造的大规模语言模型。它犹如一位博学多才的语言专家,能够解答各式各样的问题。接下来,我会从几个角度来介绍其工作原理。

预训练模型

GPT的根基在于庞大的文本数据。这相当于在浩瀚的书海中汲取养分。这些文本涵盖了众多知识领域,如新闻报道、学术论文等。通过学习这些海量文本,GPT掌握了众多概念和语义。预训练过程犹如为其播下一颗强大的语言智能种子,使其不断成长。

预训练并非易事。处理大量数据,必须运用复杂的算法进行优化。只有这样chatgpt原理,才能从文本中准确提取有用信息,为后续输出打下坚实基础。

Transformer架构

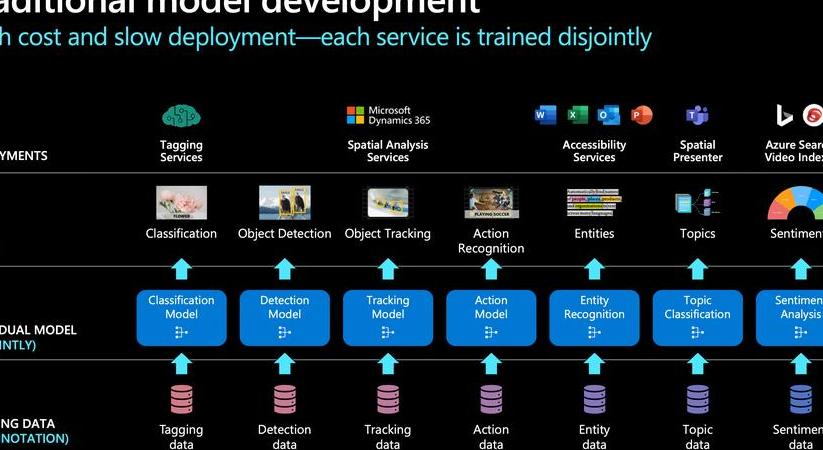

Transformer构成了GPT的基础结构。这就像是一个极其智能的大脑神经网络。与传统的神经网络相比,Transformer展现出显著的优势。例如,它能够并行处理数据chatgpt原理,显著提升了处理效率。

Transformer架构中,存在一种自注意力机制。这就像一把神奇之钥。它能引导模型关注文本的各个片段,进而更深刻地把握语境间的联系。这使得GPT在回答问题时,更加精确、更具条理。

微调与优化

然而免费ChatGPT中文版,最初的预训练模型并不能全面应对各类任务。这时,我们便需要进行调整。这就像一个学生虽然掌握了基础知识,但为了应对特定考试,还需进行有针对性的练习。通过微调,可以增强GPT在特定领域的表现能力。

通过改进算法,对模型的各项参数进行细致调整。这一步骤需格外谨慎,因为参数的细微变动可能会对最终结果产生显著的影响。这就像调整钢琴的琴弦,需要慢慢寻找最和谐的音色。

生成回复

提问GPT后,它会分析输入内容。凭借之前积累的知识和技能,GPT会生成回复。这个过程就像制作一道美味的佳肴。

挑选词汇时需遵循逻辑与语言规范,句子构建亦应如此。同时ChatGPT官网中文版,还需从众多选项中筛选出最佳答案。这个过程犹如在众多宝石中寻觅最璀璨的那颗。

关于GPTChatGPT香港,您有何独到见解?欢迎在评论区分享您的观点。同时,别忘了点赞并转发这篇文章。